BERT(Bidirectional Encoder Representations from Transformers)는 트랜스포머의 인코더를 활용한 강력한 자연어 처리 모델입니다. BERT의 주요 특징과 작동 방식은 다음과 같습니다:

구조와 작동 원리

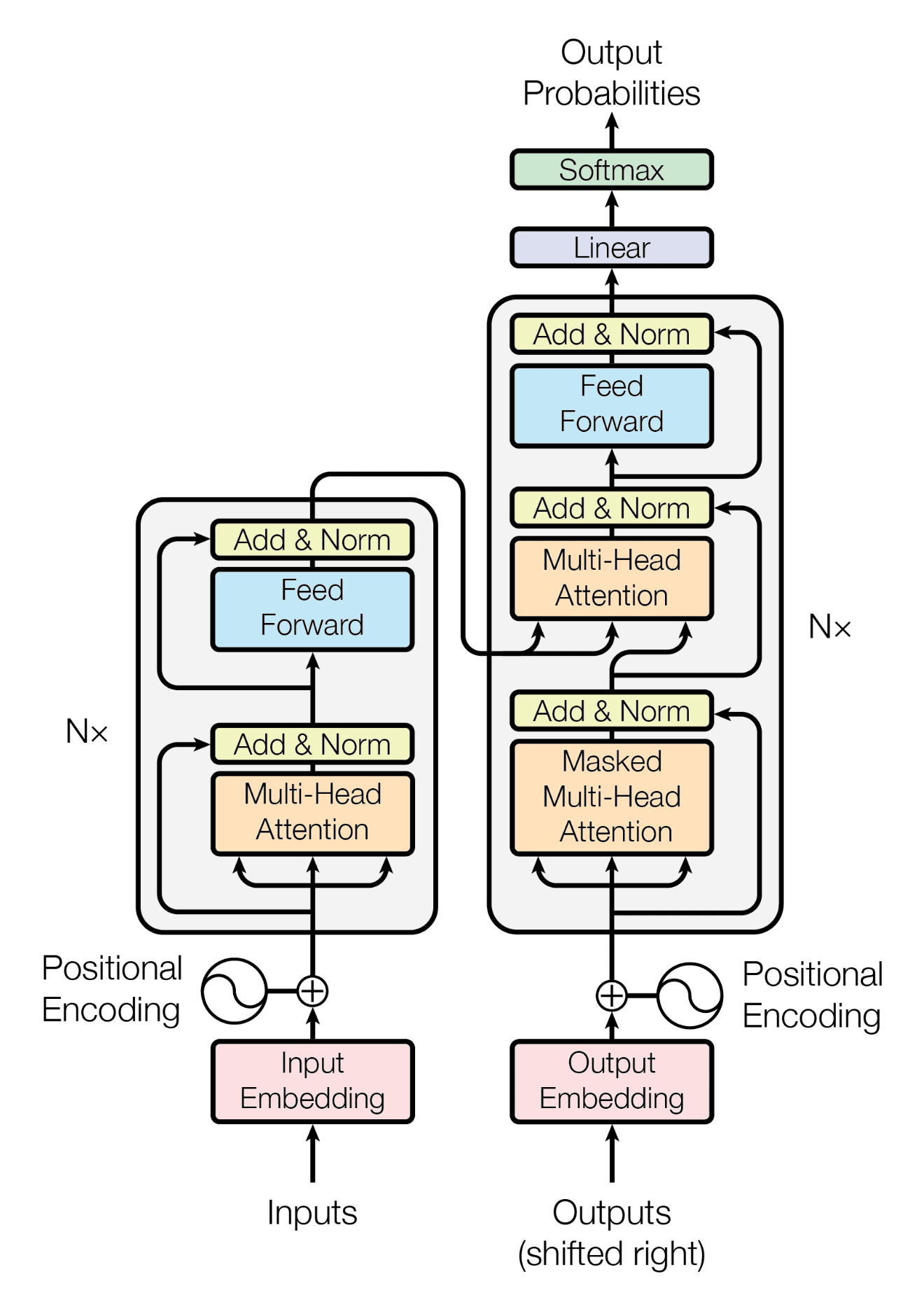

- 인코더 기반 아키텍처: BERT는 트랜스포머의 인코더 부분만을 사용합니다. 기본 모델(BERT-base)은 12개의 인코더 층으로 구성되어 있으며, 대형 모델(BERT-large)은 24개의 층을 가집니다[1][15].

- 양방향성: BERT는 문장의 전후 맥락을 동시에 고려하는 양방향 모델입니다. 이는 단어의 의미를 더 정확하게 파악할 수 있게 해줍니다[2][22].

- 자기 주의 메커니즘: 트랜스포머의 핵심인 자기 주의 메커니즘을 사용하여 문장 내 단어들 간의 관계를 효과적으로 포착합니다[14][22].

- 토큰화와 임베딩: 입력 텍스트는 토큰으로 분리되고, 각 토큰은 벡터로 변환됩니다. 이 과정에서 위치 정보와 세그먼트 정보도 함께 임베딩됩니다[14][16].

사전 학습 방법

BERT는 두 가지 주요 사전 학습 방법을 사용합니다:

- 마스크 언어 모델(MLM): 입력 문장의 일부 단어를 마스킹하고, 모델이 이를 예측하도록 학습시킵니다[2][22].

- 다음 문장 예측(NSP): 두 문장이 연속적인지 아닌지를 예측하는 작업을 통해 문장 간 관계를 학습합니다[2][22].

응용 분야

BERT는 다양한 자연어 처리 작업에 활용될 수 있습니다:

- 텍스트 분류

- 질의응답

- 개체명 인식

- 감성 분석

- 문장 유사도 측정[17][20]

BERT의 장점

- 맥락 이해: 양방향 처리를 통해 단어의 맥락을 더 잘 이해합니다[22].

- 전이 학습: 대규모 데이터로 사전 학습된 모델을 다양한 작업에 쉽게 적용할 수 있습니다[20].

- 성능: 다양한 자연어 처리 작업에서 최고 수준의 성능을 보여줍니다[1].

BERT는 인코더 기반의 강력한 언어 모델로, 양방향 문맥 이해와 효과적인 전이 학습 능력을 통해 다양한 자연어 처리 작업에서 뛰어난 성능을 보여주고 있습니다.

Citations:

[1] https://gogl3.github.io/articles/2021-02/BERT_detail

[2] https://en.wikipedia.org/wiki/BERT_(language_model)

[3] https://research.google/pubs/bert-pre-training-of-deep-bidirectional-transformers-for-language-understanding/

[4] https://spotintelligence.com/2024/02/29/bert-nlp/

[5] https://towardsdatascience.com/bert-explained-state-of-the-art-language-model-for-nlp-f8b21a9b6270?gi=eb46a49bcbf4

[6] https://www.labellerr.com/blog/bert-explained-state-of-the-art-language-model-for-nlp/

[7] https://www.geeksforgeeks.org/explanation-of-bert-model-nlp/

[8] https://jalammar.github.io/illustrated-bert/

[9] https://huggingface.co/blog/bert-101

[10] https://www.javatpoint.com/bert-applications

[11] https://www.yitay.net/blog/model-architecture-blogpost-encoders-prefixlm-denoising

[12] https://arxiv.org/html/2412.14276v2

[13] https://www.researchgate.net/publication/381035351_Research_on_the_application_of_deep_learning-based_BERT_model_in_sentiment_analysis

[14] https://serokell.io/blog/bert-explanation

[15] https://wikidocs.net/224181

[16] https://tinkerd.net/blog/machine-learning/bert-encoder/

[17] https://towardsdatascience.com/bert-explained-state-of-the-art-language-model-for-nlp-f8b21a9b6270?gi=eb46a49bcbf4

[18] https://neptune.ai/blog/how-to-code-bert-using-pytorch-tutorial

[19] https://jalammar.github.io/illustrated-bert/

[20] https://www.tensorflow.org/text/tutorials/classify_text_with_bert

[21] https://huggingface.co/blog/modernbert

[22] https://zilliz.com/learn/what-is-bert

[23] https://hazyresearch.stanford.edu/blog/2024-05-20-m2-bert-retrieval

[24] https://pmc.ncbi.nlm.nih.gov/articles/PMC7889424/

답글 남기기