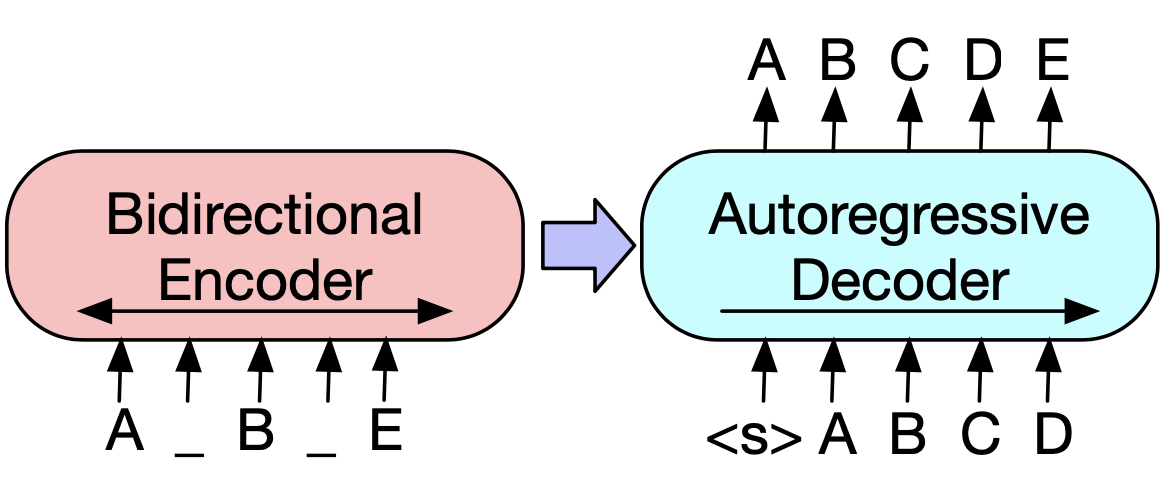

BART와 T5는 모두 인코더-디코더 구조를 사용하는 트랜스포머 기반 모델이지만, 몇 가지 주요한 차이점이 있습니다:

학습 목표와 방식

- BART:

- 문서를 손상시킨 후 원본을 재구성하는 방식으로 학습합니다[1].

- 다양한 노이즈 기법(토큰 마스킹, 삭제, 텍스트 채우기 등)을 적용합니다[3].

- T5:

- 모든 NLP 작업을 텍스트-투-텍스트 형식으로 통일하여 처리합니다[4].

- 입력 시퀀스의 15% 토큰을 무작위로 삭제하고 특수 토큰으로 대체하는 방식을 사용합니다[1].

모델 구조와 특징

- BART:

- 절대 위치 인코딩을 사용합니다[8].

- 텍스트 생성과 복원에 최적화되어 있습니다[4].

- T5:

- 상대적 위치 인코딩을 사용합니다[8].

- 다중 작업 학습에 강점이 있습니다[4].

성능과 적용

- BART:

- 요약, 데이터 복원, 스토리 생성 등의 작업에서 우수한 성능을 보입니다[4].

- 일부 연구에서는 요약 작업에서 T5보다 높은 ROUGE 점수를 기록했습니다[9].

- T5:

- 번역, 질문 응답, 요약 등 다양한 작업을 통합해 처리할 수 있습니다[4].

- 일부 연구에서는 요약 작업에서 BART보다 높은 ROUGE-1과 METEOR 점수를 기록했습니다[9].

두 모델 모두 강력한 성능을 보이지만, 특정 작업이나 데이터셋에 따라 성능 차이가 있을 수 있습니다. 따라서 실제 적용 시에는 해당 작업에 맞는 모델을 선택하거나 비교 실험을 통해 결정하는 것이 좋습니다.

Citations:

[1] https://stackoverflow.com/questions/77732511/what-are-differences-between-t5-and-bart/77774322

[2] https://www.researchgate.net/figure/Performance-comparison-using-several-types-of-BART-and-T5-on-DialogSum_tbl2_373542055

[3] https://dev.to/admantium/large-language-models-comparing-gen-1-models-gpt-bert-t5-and-more-74h

[4] https://velog.io/@jayginwoolee/BERT-SBERT-BART-T5-%EA%B0%84%EB%8B%A8-%EC%84%A4%EB%AA%85

[5] https://www.cs.utexas.edu/~gdurrett/courses/fa2021/lectures/lec24-4pp.pdf

[6] https://discuss.huggingface.co/t/what-is-the-difference-between-t5-and-bart-model/12452

[7] https://discuss.huggingface.co/t/t5-outperforms-bart-when-fine-tuned-for-summarization-task/20009

[8] https://www.ee.cityu.edu.hk/~lmpo/ee4016/pdf/2024A_AI_L06D_BART-T5.pdf

[9] https://www.iieta.org/download/file/fid/132319

답글 남기기