크로스 어텐션(Cross-Attention)은 트랜스포머(Transformer) 아키텍처에서 사용되는 주요 메커니즘 중 하나로, 두 개의 서로 다른 입력 시퀀스를 결합하는 방식입니다. 크로스 어텐션의 주요 특징과 작동 방식은 다음과 같습니다:

기본 개념

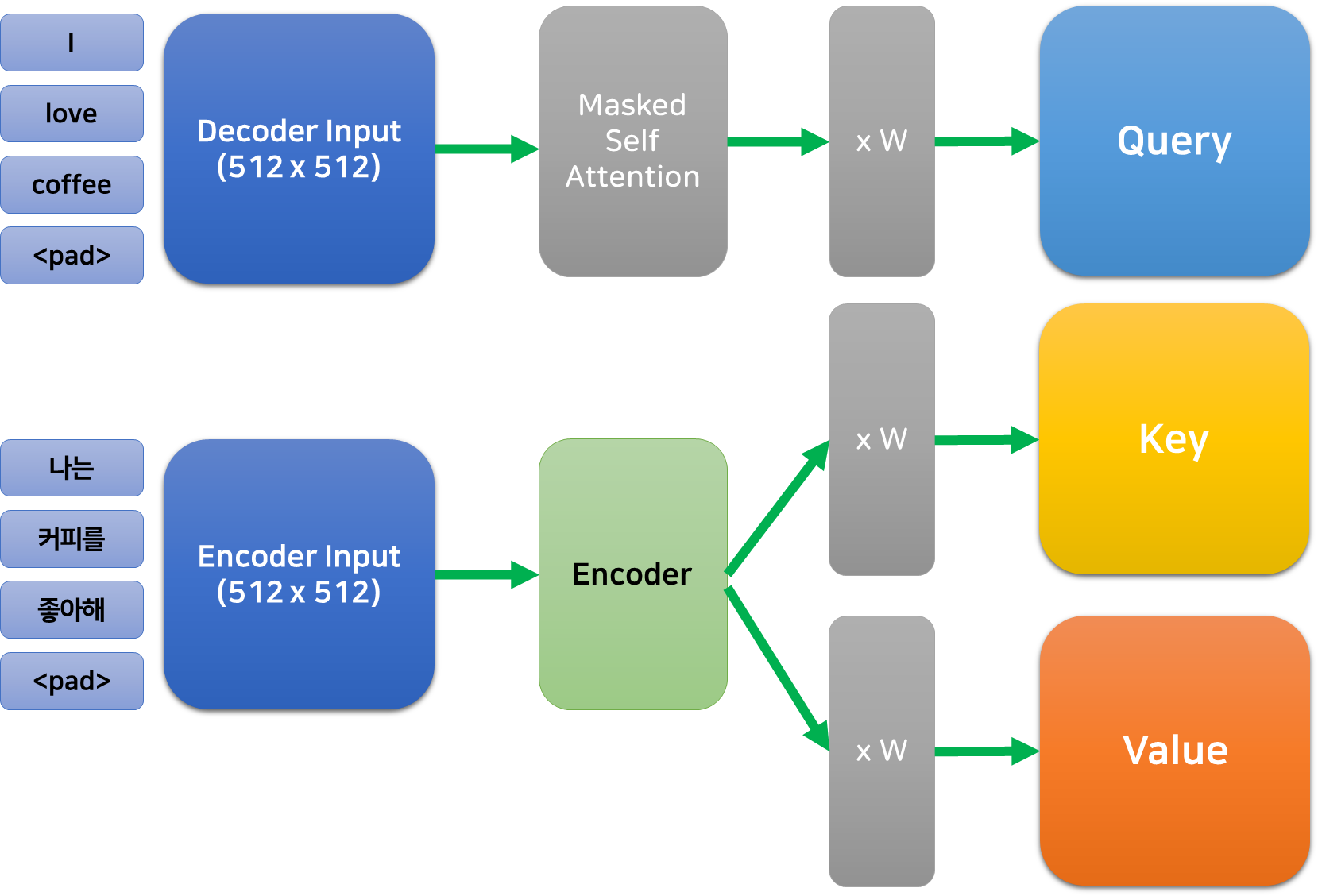

크로스 어텐션은 셀프 어텐션(Self-Attention)과 달리 서로 다른 두 입력 시퀀스를 다룹니다[1][4]. 일반적으로 한 시퀀스에서 쿼리(Query)를 생성하고, 다른 시퀀스에서 키(Key)와 값(Value)을 생성합니다[6].

작동 원리

- 입력 구조: 크로스 어텐션은 두 개의 다른 입력 시퀀스를 사용합니다. 예를 들어, 기계 번역에서는 소스 문장과 타겟 문장이 될 수 있습니다[5].

- 쿼리, 키, 값 생성:

- 쿼리(Q): 일반적으로 디코더의 현재 상태에서 생성됩니다.

- 키(K)와 값(V): 인코더의 출력에서 생성됩니다[12].

- 어텐션 계산: 쿼리와 키를 사용하여 어텐션 스코어를 계산하고, 이를 값과 곱하여 최종 출력을 생성합니다[1].

응용 분야

크로스 어텐션은 다양한 분야에서 활용됩니다:

- 기계 번역: 소스 언어와 타겟 언어 간의 관계를 모델링합니다[5].

- 이미지 캡셔닝: 이미지 특징과 텍스트 생성을 연결합니다[5].

- 멀티모달 학습: 텍스트, 이미지, 음성 등 다양한 모달리티 간의 관계를 학습합니다[8].

장점

- 정보 융합: 서로 다른 도메인의 정보를 효과적으로 결합할 수 있습니다[10].

- 선택적 집중: 관련성 높은 정보에 집중할 수 있어 효율적인 정보 처리가 가능합니다[14].

- 유연성: 다양한 길이와 구조의 입력을 처리할 수 있습니다[5].

크로스 어텐션은 트랜스포머 모델의 핵심 구성 요소로, 복잡한 시퀀스 간 관계를 모델링하는 데 중요한 역할을 합니다. 이를 통해 모델은 서로 다른 입력 소스의 정보를 효과적으로 통합하고, 더 정확하고 맥락에 맞는 출력을 생성할 수 있습니다.

Citations:

[1] https://brunch.co.kr/@leadbreak/10

[2] https://www.youtube.com/watch?v=aw3H-wPuRcw

[3] https://magazine.sebastianraschka.com/p/understanding-and-coding-self-attention

[4] https://kongsberg.tistory.com/47

[5] https://aiml.com/explain-cross-attention-and-how-is-it-different-from-self-attention/

[6] https://www.reddit.com/r/deeplearning/comments/nf08zz/what_is_the_cross_attention/

[7] https://skyil.tistory.com/256

[8] https://paperswithcode.com/method/cross-attention-module

[9] https://jjuke-brain.tistory.com/entry/%EB%94%A5%EB%9F%AC%EB%8B%9D-%EA%B8%B0%EC%B4%88-Attention-Transformer

[10] https://velog.io/@letsbe/CrossViT-Cross-Attention-Multi-Scale-Vision-Transformer-for-Image

[11] https://zzziito.tistory.com/56

[12] https://www.linkedin.com/posts/damienbenveniste_what-is-the-difference-between-self-attention-activity-7211029906166624257-m0Wn

[13] https://kimjy99.github.io/%EB%85%BC%EB%AC%B8%EB%A6%AC%EB%B7%B0/prompt-to-prompt/

[14] https://rbcborealis.com/research-blogs/tree-cross-attention/

[15] https://www.kaggle.com/code/aisuko/coding-cross-attention

답글 남기기